Kirchhoff の行列木定理をランダムウォークで証明する論文が面白かったので整理する.

Determinants, their applications to Markov processes, and a random walk proof of Kirchhoff's matrix tree theoremKirchhoff's matrix tree theorem is a well-known result that gives a formula

for the number of spanning trees in a finite, connected graph in terms of the

graph Laplacian matrix. A closely related result is Wilson's algorithm for

putting the uniform distribution on the set of spanning trees. We will show

that when one follows Greg Lawler's strategy for proving Wilson's algorithm,

Kirchhoff's theorem follows almost immediately after one applies some

elementary linear algebra. We also show that the same ideas can be applied to

other computations related to general Markov chains and processes on a finite

state space.

ランダムウォークから行列木定例を証明する

行列木定理は,連結グラフにおける全域木の数に関する定理である. よく知られている証明方法は純粋な代数学と Cauchy-Binet の公式によって導くものである. 一方で,arXiv:1306.2059 における証明方法は とてもユニークで「ランダムウォークによってすべての全域木を等確率で生成する Wilson’s Algorithm 」を使う. すべての全域木を等確率で生成するのだから,その確率の逆数がグラフにおける全域木の総数と一致する. なので全域木の数を求める問題が「Wilson’s Algorithm における全域木 (uniform spanning tree; UST) の生成確率を求める問題」に変わるわけである. その発想はなかった. よく知られる証明方法と違い,この証明に必要なものはランダムウォークを扱うためのマルコフ連鎖とほんの少しの代数学的な操作(Cramer の公式から導き出される等式)である.

おさらい

頂点集合 V={y1,y2,⋯,yn+1},辺集合 E の無向連結グラフ Γ=(V,E) について考える. グラフラプラシアン行列を L=D−A と定義する. D は対角成分がグラフの次数となる次数行列,A は隣接行列である.L{k} を L から k 行 k 列を取り除いた部分行列とする.

定理: Kirchhoff の行列木定理

Ω={spanning trees ofΓ} としたとき,

∣Ω∣=det[L{1}]=⋯=det[L{n+1}]

が成立する.

すなわち,グラフラプラシアンに対して任意の要素に対する行と列を削除し,その部分行列の determinant が全域木の数と一致する. 以降では Wilson’s Algorithm を紹介して,ランダムウォークを用いた行列木定理の証明過程を紹介する.

Loop-erased Random Walk (LERW) & Wilson’s algorithm

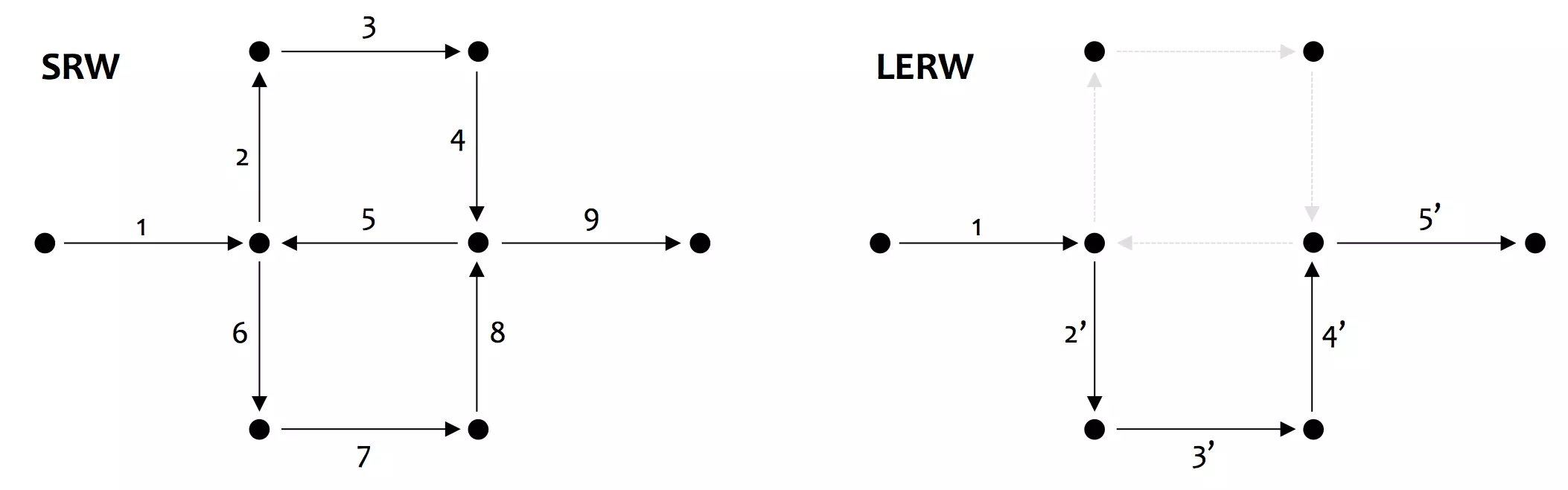

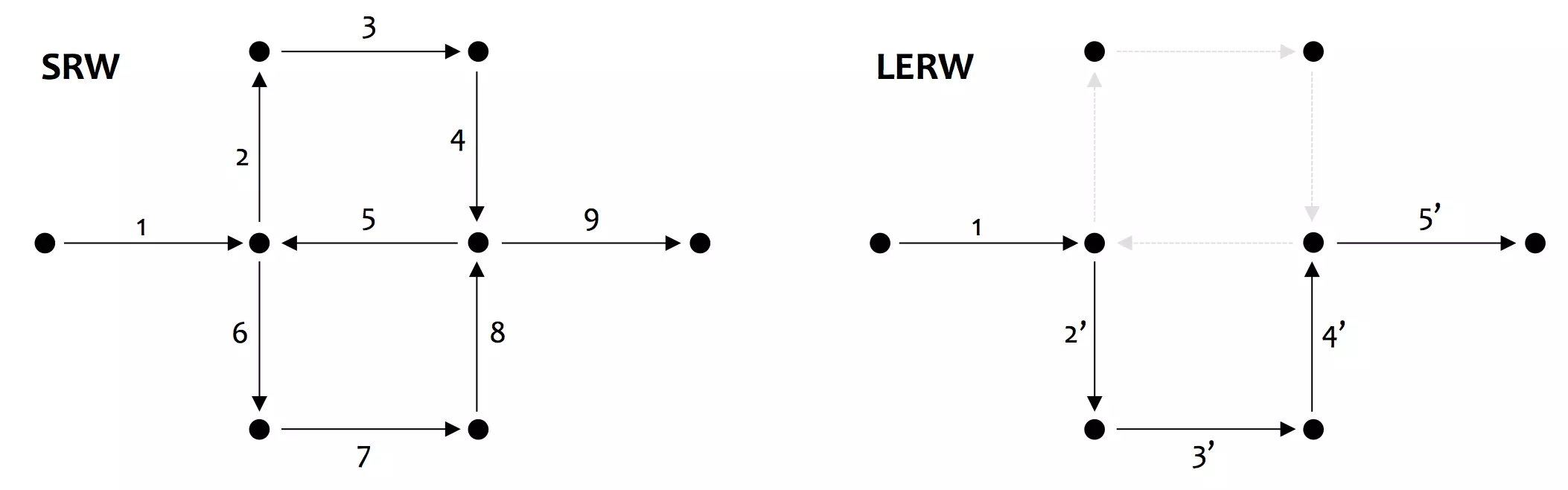

普通の単純ランダムウォーク (SRW) をグラフ上で実行した場合,そのパスはループ(閉路や多重辺)を生成する可能性がある. これに対して,ループ除去ランダムウォーク (LERW) は SRW からループが発生した時系列順にループを除去することで,ループのないパスを生成する.

Figure: 左図は単純ランダムウォーク (Simple Random Walk; SRW)、右図はループ除去ランダムウォーク (Loop-erased Random Walk; LERW) の例

Figure: 左図は単純ランダムウォーク (Simple Random Walk; SRW)、右図はループ除去ランダムウォーク (Loop-erased Random Walk; LERW) の例

λ=(y1,y2,⋯,yj) を無向連結グラフ Γ=(V,E) のパスとする.LE(λ) を SRW でループが発生した時系列順にループを除去したパスとする(LE は loop-erasure の略).LE({Sk,k=0,⋯}) ループ除去ランダムウォーク (Loop-erased Random Walk; LERW) と呼ぶ.

Wilson’s Algorithm

Wilson’s Algorithm は LERW によって得た loop-erasure のパスを branch として,これまでに生成した部分木に追加していくことで全域木を生成する.

- 初期の branch を生成: 頂点 y0,y1 を選択し,y0 から y1 まで LERW を実行する.得たパスを Δ1 とする.

- branch の追加: Δk が与えられたとき,頂点 yk+1∈V∖Δk を選択する. yk+1 から Δk までの LERW と Δk の和集合をとり Δk+1 とする.

- 繰り返し: Δk が頂点集合 VV と一致するまで (2) を繰り返す.

全域木の生成仮定を D3.js で可視化した例 を見ると明らかであるが, 全域木を生成するためのアルゴリズムとして実行速度という面では非効率的な方法である. UST を生成するという特異な性質は注目に値するが, いままでに探索した頂点への再訪を許すアルゴリズムとなっているので, Δk から遠ざかる方向にランダムウォークするとなかなか木が生成されない.

グラフの定義

Wilson’s Algorithm における全域木の生成確率を導出するために,グラフ上のランダムウォークと行列を用意する. グラフ Γ 上の SRW を {Sk,k=0,1,⋯} と表記する. このときの遷移確率を以下のように定義する.

P{S1=yj∣S0=yi}=p(i,j)

ただし

p(i,j)=deg(yi)1ifyiis connected toyj

p(i,j)=0ifyiis not connected toyj

とする.

p(i,j) を i,j 成分に持つ transition matrix を P と表記する. D は対角行列であるため,その逆数を使い P=D−1A が成り立つ.

おさらいの節でグラフラプラシアン行列を L=D−A で定義したことを思い出す. 定義からグラフラプラシアン行列は以下のように式変形できる.

L=D(I−D−1A)=D(I−P)

ここで Δ⊂V,Δ=∅ としたとき, 任意の行列 M から Δ に対応する行と列を削除して得られる行列を MΔ と表記する. このとき,

LΔ=DΔ(IΔ−PΔ)

が成り立つ. 加えて,生成確率の導出の準備として2つの重要な役割を果たす Fact を導出する.

Fact1: グリーン関数

S0≡x としたときのマルコフ連鎖の確率分布を Px,

その期待値を Ex と表記する.

最初に Δ に到着する時間を ξΔ≡inf{n≥0:Sn∈Δ} と定義する. ランダムウォークで Δ に到達するまでにある頂点 y に到達する回数の期待値 GΔ(x,y) を考える.

GΔ(x,y)=Ex[n=0∑ξΔ1{y}(Sn)]=n=0∑∞Px(Sn=yandξΔ>n)

2番目の項は「時間 n に頂点 y にいる」ことを示す指示関数 1{y}(Sn) を使い期待値で表記している.3番目の項は確率の和によって期待値との等式が成立している.

y∈/Δ であるため,右辺の確率分布 Px は Δ に対応する行と列を取り除いた遷移行列の部分行列 PΔ で置き換えることができる.すなわち,

n=0∑∞Px(Sn=yandξΔ>n)=n=0∑∞(PΔ)xyn

右辺の無限級数は,線形代数の初等的な結果から逆数の項への式変形ができる.

n=0∑∞(PΔ)xyn=((I−P)Δ)xy−1

これは,

(I−PΔ)n=0∑∞(PΔ)n

=(I−PΔ)((PΔ)0+(PΔ)1+⋯)=(I+PΔ+(PΔ)2+⋯)−(PΔ+(PΔ)2+⋯)=I

に対して,両辺に左から ((I−P)Δ)−1 をかけることで得ることができる.

これらの結果から 「ランダムウォークで Δ に到達するまでにある頂点 y に到達する回数の期待値」を成分に持つ行列を GΔ=[GΔ(x,y)]x,y∈V∖Δ としたとき,

GΔ=(IΔ−PΔ)−1

また, rΔ(x) を x から SRW をはじめて,Δ に到達する前に x に戻る確率 rΔ(x)≡Px(τx(1)<ξΔ) としたとき,

GΔ(x,x)=k=0∑∞rΔ(x)k=1−rΔ(x)1

Fact2: Cramer の公式

Cramer の公式は,

(M−1)ii=det[M]det[M{i}]

ここから帰納法によって,ただちに以下の等式を導くことができる.

det[M]−1=det[M−1]=j=1∏N(MΔj)σ(j)σ(j)−1

(なお (σ(1),⋯,σ(N)) は (1,⋯,N) の permutation. 任意の順番で削除できるため)

Wilson’s Algorithm によって全域木を生成する確率

Δ⊂V,Δ=∅ とする. いま V∖Δ の連結した distinct element を x1,⋯,xK とし,xj∼xj+1forj=1,⋯,K とする.xK+1∈Δ とする. 頂点 x1 からグラフ Γ 上を LERW することを考える.

差集合 V∖Δ のすべての頂点に訪問し,K+1 で Δ に到達するようなパスを考える.LERW によって特定の経路を遷移する確率 を以下のように表記する.

PΔ(x1,⋯,xK,xK+1)

:=P{LE({Sj,j=0,⋯,ξΔ}) =[x1,⋯,xK,xK+1]}

[x1,⋯,xK,xK+1] は Loop-erasure によるパスであることから,明らかにループのないパスとなっている. Δ まで LERW するという操作は,Wilson’s Algorithm の branch を追加する操作に対応する.この手続きを分解すると,以下のようになる:

- x1 から 0 回以上 x1 へ loop back (x1 に戻る回数を m1 とする)

- x1 から x2 へ p(x1,x2) で遷移

- x2 から 0 回以上 x2 へ loop back (x2 に戻る回数を m2 とする)

- x2 から x3 へ p(x2,x3) で遷移

- 以下,同様の手続きを K+1 に到達するまで繰り返す

この手順を定式化すると PΔ(x1,⋯,xK,xK+1) は以下のように書ける.

PΔ(x1,⋯,xK+1)=m1,⋯,mK=0∑∞rΔ(x1)m1p(x1,x2)rΔ∪{x1}(x2)m2p(x2,x3)⋯

⋯rΔ∪{x1,⋯,xK−1}(xK)mKp(xK,xK+1)

loop back する回数は mj とおき,すべての loop back 回数の組み合わせで確率を計算し,その和をとっている.

表記を簡略化するために Δ(1)=Δ であり j=2,⋯,K に対して Δ(j)=Δ∪{x1,⋯,xj−1} であるとする.すると rΔ∪{x1} を rΔ(1) と記述できるようになるので,上式は以下のように変形できる.

=j=1∏K[deg(xj)1mj=0∑∞rΔ(j)(xj)mj]

=j=1∏Kdeg(xj)11−rΔ(j)(xj)1

=j=1∏Kdeg(xj)1GΔ(j)(xj,xj)

先に述べたとおり,PΔ(x1,⋯,xK+1) は branch を追加する操作に他ならない. これを各 branch に対しても同様に計算し,積をとることで全域木の生成確率を求めることができる. したがって,Wilson’s Algorithm が tree T を生成する確率は,

P(Tis generated by Wilson’s algorithm)

=l=1∏LPΔl(xl,1,⋯,xl,kl)

=l=1∏Lj=1∏kl−1deg(xl,j)GΔl(j)(xl,j,xl,j)

この等式は Lawler によって証明された結果である[1]. この確率は先に用意した Fact を使い,さらに簡潔にできる.

Determinant を使った式に変形

先に述べた GΔ=(IΔ−PΔ)−1 と LΔ=DΔ(IΔ−PΔ) を思い出す.線形代数の結果 (Fact2) から,

det[G{v}]=l=1∏Lj=1∏kl−1GΔl(j)(xl,j,xl,j)

det[D{v}]=l=1∏Lj=1∏kl−1deg(xl,j)

これらの結果を使い,

P(Tis generated by Wilson’s algorithm)

=det[D{v}]det[G{v}]=det[D{v}]det[I{v}−P{v}]1=det[L{v}]−1

最初の等式で Lawler の結果と直前の式, 次に GΔ の式と行列式の乗法性, 最後に LΔ の式と行列式の乗法性を使う. 生成される全域木は UST であることから,生成確率は全域木の数の逆数となる.したがって,

P(Tis generated by Wilson’s algorithm)

=det[L{v}]−1=∣Ω∣1

得られた結果は任意の頂点からスタートして成立するため,行列木定理は vv に各頂点をあてはめることで即座に得ることができる.

Reference

Random Walk Proof に関わる話は arxiv にアップされた論文 [2] の著者のスライド [3] を参考にして構成している.

基本的には原文と同様の式展開をするが,個人的にわかりづらかった部分はいくらか補足や変更を加えている(グリーン関数,LERW を使った説明,記号の整理).

元の論文と異なり,確率分布には Px を使い,遷移確率には P を使い,マルコフ連鎖の状態を Sk に統一している.

- [1] G. F. Lawler and V. Limic, Random Walk: A Modern Introduction. Cambridge University Press, 2010.

- [2] Michael J. Kozdron, Larissa M. Richards and Daniel W. Stroock, Determinants, their applications to Markov processes, and a random walk proof of Kirchhoff’s matrix tree theorem, Preprint, 2013. Available online at arXiv:1306.2059.

- [3] A random walk proof of Kirchhoff’s matrix tree theorem

Figure: 左図は単純ランダムウォーク (Simple Random Walk; SRW)、右図はループ除去ランダムウォーク (Loop-erased Random Walk; LERW) の例

Figure: 左図は単純ランダムウォーク (Simple Random Walk; SRW)、右図はループ除去ランダムウォーク (Loop-erased Random Walk; LERW) の例